Deep State Space Models for Time Series Forecasting

Deep State Space Models for Time Series Forecastingを読んでまとめました。

解釈間違い等ある時がありますので、その場合指摘いただけると助かります。

目次

概要

- 状態空間モデルとディープラーニングを組み合わせた確率的時系列予測。

- 状態空間モデルに必要なデータの効率性や解釈性を維持しながら、深層学習により複雑なパターンを学習する。

- 共変量から状態空間モデルパラメータへのマッピングにRNN(LSTM)が使われている。

- 少ない学習データへの構造的仮定を組み込んだ対応から、大規模な時系列データから複雑なパターンを学習する事まで適用可能。

問題定義

- 確率予測問題を以下と定義

- N:一変量時系列集合とする。

この問題で解きたいのは、将来の軌道確率分布であり、以下で表される。

State Space Models

方程式

- 線形の状態遷移方程式となるモデルを考えると以下の式となる。

- また、一変量ガウス状態空間モデルとすると、以下となる

Parameter learning

- 状態空間モデルは、パラメータで完全に指定される。

- この論文では一般的なパラメータの推定方法として周辺尤度の最大化があげられている。

Deep State Space Models

学習

- 本アルゴリズムでは、各時系列毎に独立した状態空間パラメータ

を学習するのではなく、以下のmappingを学習する。

また、パラメータは以下の対数尤度関数を最大化する条件で推定される

- モデルの概観は以下となる。

Prediction

状態空間モデルから予測サンプルを生成するために、training rangeの最後のステップTの時点での隠れ状態を推定。

その後遷移方程式と観測方程式を再帰的に使い予測サンプルを生成する。

本論文ではカルマンフィルタの模様

結果

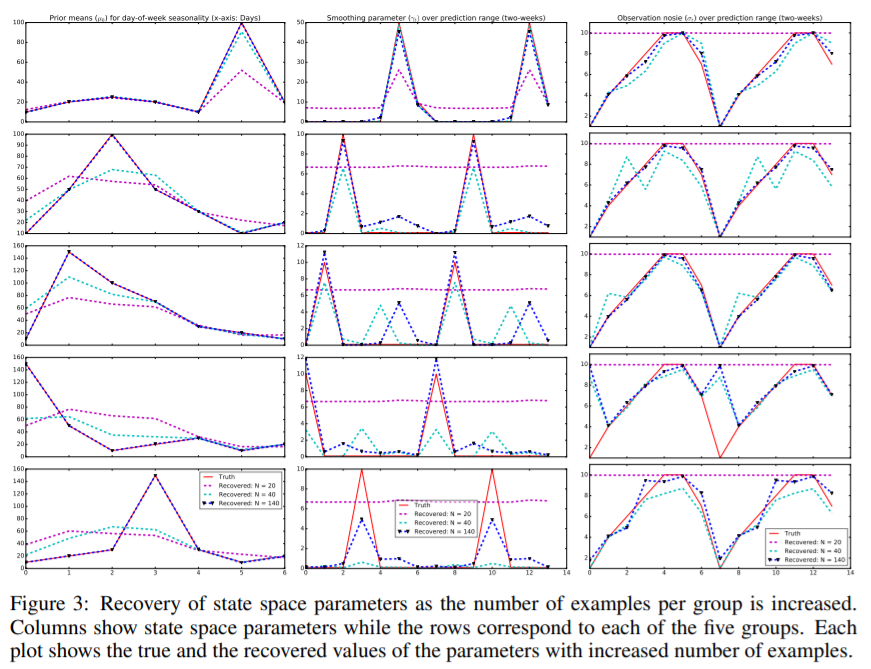

- 合成データを用いて検証する事で、データが生成された状態空間モデルのパラメータの復元が出来る事が示されている。

参考文献

https://pdfs.semanticscholar.org/7b8f/97663a190ddaf599f83d3ab6204639f8881a.pdf