Explainable k-Means and k-Medians Clustering

Explainable k-Means and k-Medians Clustering(ICML2020 Accepted paper)を読んでまとめました。

解釈間違い等ある時がありますので、その場合指摘いただけると助かります。

目次

背景と概要

- clusteringは幾何学データの教師なし学習の代表例だが、多くのclusteringアルゴリズムはデータの全特徴量に複雑に依存するため説明が困難

- 解釈性向上のため小さい決定木によるデータセットの分割を行った。→Explainable k-Means and k-Medians Clustering

- 教師なし決定木:Threshold treeと本論文では読んでいる

- アルゴリズム

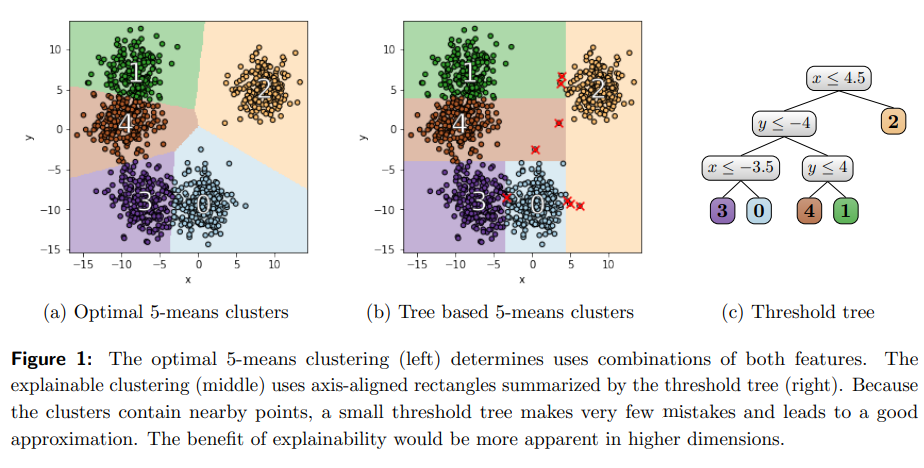

- 通常のk-means clusteringとTree based clusteringの概観が以下のように示されている。

- 本論文では、このClusterの分割され方を以て説明性が上がったとしている。

- 図における✖印がmistakeと定義されている。この数を最小化する事も今回のアルゴリズムに含まれている。

k-means、k-median clustering

- k-meansとk-medianのゴール:与えられた集合

をk個の部分集合に分割してcluster中心までの点の距離を最小化

Explainable k-Means and k-Medians Clustering

- 以下の順番で記載

- threshold treesを使ったClustering

- k=2の場合のSingle Threshold Cutを用いたClustering

- k>2の場合のClustering:Iterative Mistake Minimization (IMM) algorithm

threshold treesを使ったClustering

- 2つのclusterを定義する最も単純な方法:1つの特徴量の閾値に基づいてデータを分割する事となる(Single Threshold Cut)。

- k>2の場合には、上記に閾値に基づいた分割(Binary Threshold Cut)を反復的に用いる。

- これらに基づいたk個の葉をもつthreshold treeによるk-medians、k-meansのコストは以下となる。

k=2の場合のSingle Threshold Cutを用いたClustering

- 2-meansの場合を考える。

- k=2の場合のコストは以下となる。

- 右辺第一項:1つ目のClusterについての計算、第二項:2つ目のClusterについての計算

k>2の場合のClustering:Iterative Mistake Minimization (IMM) algorithm

アルゴリズム

- 最初のステップ:k-meansやk-mediansといったアルゴリズムによるcluster centersを参照セットとする。

- 各データ点

に最も近いcluster centersのラベル

を割り当てる。

- 各データ点

- 以下がbuild tree procedureと呼んでいる決定木の構築ステップとなる。

- 以下が今回のアルゴリズムを示している。